python利用proxybroker構建爬蟲免費IP代理池的實現

寫爬蟲的小伙伴可能遇到過這種情況:

正當悠閑地喝著咖啡,滿意地看著屏幕上的那一行行如流水般被爬下來的數據時,突然一個Error彈出,提示抓不到數據了...

然后你反復檢查,確信自己代碼莫得問題之后,發現居然連瀏覽器也無法正常訪問網頁了...

難道是網站被我爬癱瘓了?

然后你用手機瀏覽所爬網站,驚奇地發現居然能訪問!

才原來我的IP被網站給封了,拒絕了我的訪問

這時只能用IP代理來應對禁IP反爬策略了,但是網上高速穩定的代理IP大多都收費,看了看皺皺的錢包后,一個大膽的想法冒出

我要白嫖!

啥是IP代理?假如你現在17歲未成年,理想一點的情況會是,你去商店買煙,老板告訴你未成年不能買煙,并拒絕了你的購買,這叫被服務器拒絕訪問;

但是你不服氣啊,于是你找來你20歲的哥哥,叫他去商店老板那幫你買包煙,然后再給你,這就叫IP代理。

ProxyBroker簡介ProxyBroker是一個開源軟件,它從各種不同的IP代理網站中抓來公開的代理IP,并實時地檢查代理IP的可用性,以供使用。

所以可以說ProxyBroker是一個集成了爬蟲技術的開源軟件。

ProxyBroker安裝你可以通過pip來安裝ProxyBroker

pip install proxybroker

也可以直接從Github下載最新版本的ProxyBroker

pip install -U git+https://github.com/constverum/ProxyBroker.git在終端使用ProxyBroker

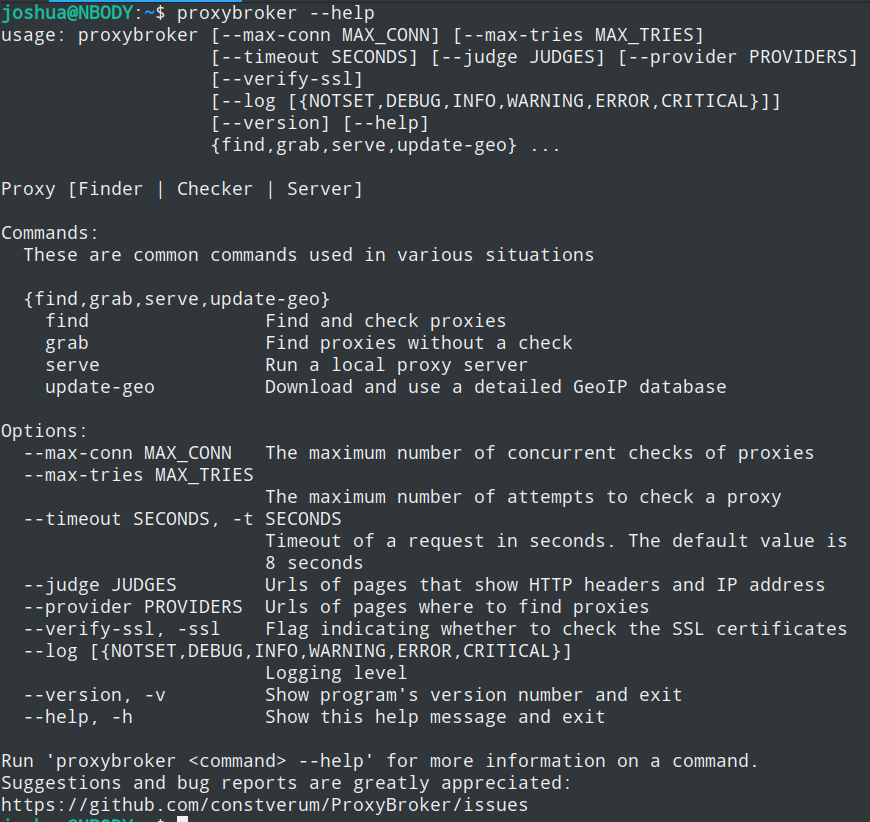

安裝成功后,你可以在終端中使用命令proxybroker

proxybroker主要有三個子命令

find子命令find子命令用于查找并檢查公開的代理IP,換言之它會列出所有經測試可用的代理IP

下列是find子命令的常用選項:

選項 作用 可選值 示例 --types 指定代理的類型 HTTP,HTTPS,SOCKS4,SOCKS5,CONNECT:80,CONNECT:25 --types HTTP HTTPS --lvl 指定代理的匿名級別 Transparent,Anonymous,High --lvl High --strict,-s 嚴格保證代理的類型與匿名級別等于指定的值 只要加上就表示啟用嚴格模式 --strict --countries COUNTRIES,-c COUNTRIES 指定代理IP的所屬國家 US,CN... -c CN --limit LIMIT, -l LIMIT 指定獲取的條數 正整數即可 -l 5 --outfile OUTFILE, -o OUTFILE 將找到的代理保存到文件中 文件路徑 --outfile ./proxies.txt --format FORMAT, -f FORMAT 指定輸出的格式,默認值為default default,json -f json --post 用post請求檢查IP的可用性,默認是用get方式 只要加上就表示啟用post請求檢查 --post --show-stats 是否打印詳細統計信息 只要加上就表示啟用打印統計信息 --show-stats

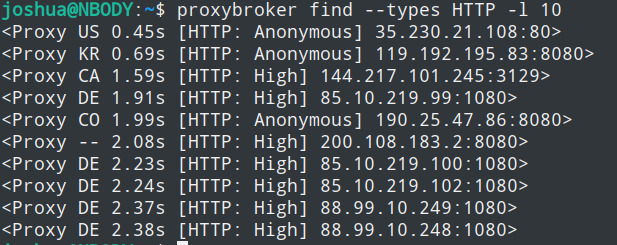

比如查找10條HTTP代理

proxybroker find --types HTTP -l 10

你可以將選項的示例值加上,自己嘗試一下

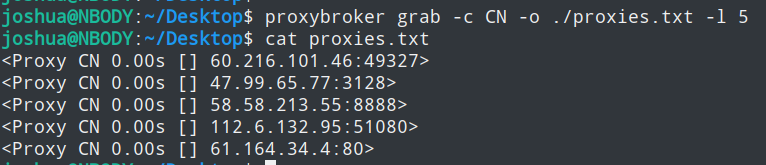

grab子命令grab子命令有點像find的簡易版,它只進行查找,并不檢查抓來IP的可用性

下列是grab子命令的所有選項:

選項 作用 可選值 示例 --countries COUNTRIES,-c COUNTRIES 指定代理IP的所屬國家 US,CN... -c CN --limit LIMIT, -l LIMIT 指定獲取的條數 正整數即可 -l 5 --outfile OUTFILE, -o OUTFILE 將找到的代理保存到文件中 文件路徑 --outfile ./proxies.txt --format FORMAT, -f FORMAT 指定輸出的格式,默認值為default default,json -f json --show-stats 是否打印詳細統計信息 只要加上就表示啟用打印統計信息 --show-stats

可以看到它有的選項,find子命令都有,所以它是find的閹割版

比如查找5條來自中國的代理,并將它保存至文件中

proxybroker grab -c CN -o ./proxies.txt -l 5

serve子命令用于搭建一個本地代理服務器,它可以分發你的請求至不同的IP代理中

下列是serve子命令的常用選項:

選項 作用 可選值 示例 --host HOST 指定服務器的地址,默認是127.0.0.1 你本機的IP --host localhost --port PORT 指定服務器的端口,默認是8888 你本機可用的端口 --port 5000 --max-tries SRV_MAX_TRIES 設置處理請求的最大重試次數 正整數 --max-tries 3 --min-req-proxy MIN_REQ_PROXY 設置每個IP處理請求的最小次數 正整數 --min-req-proxy 3 --http-allowed-codes HTTP_ALLOWED_CODES 設置允許代理返回的響應碼 響應的狀態碼 --http-allowed-codes 302 --max-error-rate MAX_ERROR_RATE 設置最大允許請求的異常率,例如0.5是50% 0~1 --max-error-rate 0.3 --max-resp-time SECONDS 設置響應的最大允許秒數,默認是8秒 秒數 --max-resp-time 20 --prefer-connect 如果可以的話,是否使用CONNECT方法 只要加上就表示使用 --prefer-connect --backlog BACKLOG 設置連接隊列的最大值 正整數即可 --backlog 10 - - - - --types 指定代理的類型 HTTP,HTTPS,SOCKS4,SOCKS5,CONNECT:80,CONNECT:25 --types HTTP HTTPS --lvl 指定代理的匿名級別 Transparent,Anonymous,High --lvl High --strict,-s 嚴格保證代理的類型與匿名級別等于指定的值 只要加上就表示啟用嚴格模式 --strict --countries COUNTRIES,-c COUNTRIES 指定代理IP的所屬國家 US,CN... -c CN --limit LIMIT, -l LIMIT 指定代理池的工作IP條數 正整數即可 -l 5

serve子命令搭建代理服務器,相當于把我們本機變成中間商再中間商

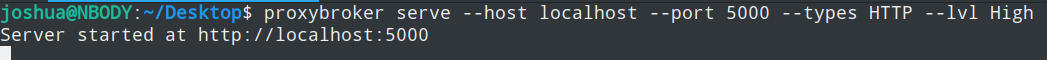

比如在地址為localhost,端口為5000,搭起高匿名代理服務器

proxybroker serve --host localhost --port 5000 --types HTTP --lvl High

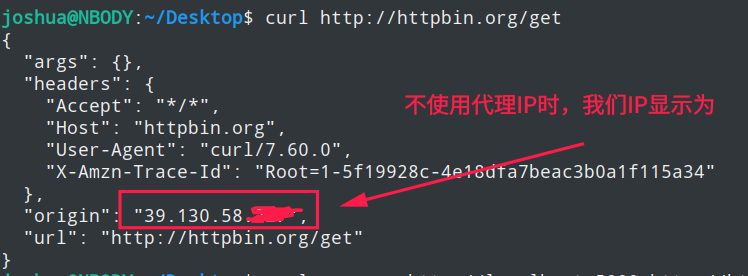

然后先通過curl命令不使用代理訪問一下http://httpbin.org/get這個地址,查看一下該網站顯示我們的IP是多少

curl http://httpbin.org/get

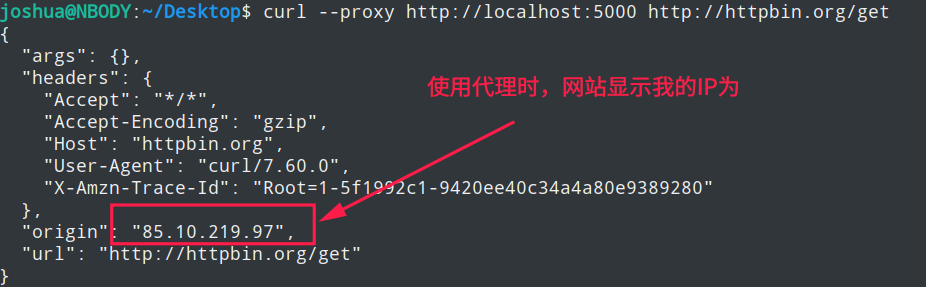

再使用curl命令通過我們剛搭起的代理服務器訪問一下,看看網站顯示的IP是否有變化

curl --proxy http://localhost:5000 http://httpbin.org/get

你可以通過proxybroker serve子命令搭起代理服務器,然后在發起請求時使用該代理,這種方法適用于幾乎所有的編程語言

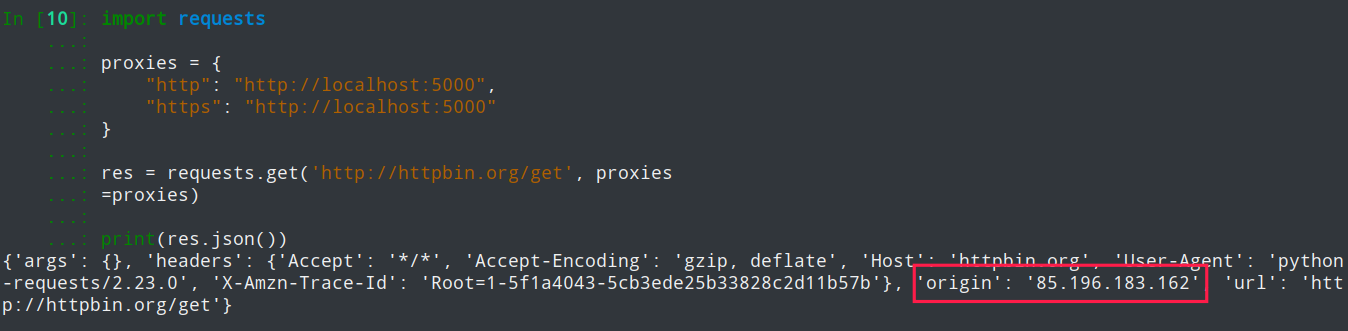

requests庫使用代理先serve搭起代理服務器

proxybroker serve --host localhost --port 5000 --types HTTP --lvl High

然后通過requests庫設置代理

import requestsproxies = { 'http': 'http://localhost:5000', 'https': 'http://localhost:5000'}res = requests.get(’http://httpbin.org/get’, proxies=proxies)print(res.json())

效果如下

還是先serve搭起代理服務器,代碼還是和上面一樣

在終端中,通過scrapy startproject新建一個爬蟲項目,然后進入該項目目錄里

scrapy startproject proxy_democd proxy_demo

通過scrapy genspider新建一個爬蟲,名為proxy_spider_demo,域名為httpbin.org

scrapy genspider proxy_spider_demo httpbin.org

然后將下列代碼粘貼至剛剛新建的爬蟲中

import jsonimport scrapy# from scrapy.downloadermiddlewares.httpproxy import HttpProxyMiddlewareclass ProxySpiderDemoSpider(scrapy.Spider): name = ’proxy_spider_demo’ allowed_domains = [’httpbin.org’] # start_urls = [’http://httpbin.org/’] def start_requests(self): meta = dict(proxy=’http://localhost:5000’) # 請求三次該網址,查看IP是否不同 for _ in range(3): # 得加上dont_filter=True,否則第2、3個請求將被dupefilter過濾 # 請求可以通過meta攜帶代理服務器地址,與HttpProxyMiddleware下載器中間件配合達到代理請求的目的 yield scrapy.Request(’http://httpbin.org/get’, dont_filter=True, meta=meta, callback=self.parse) def parse(self, response): json_body = json.loads(response.text) print(’當前請求的IP為:’, json_body[’origin’])

在項目根目錄處進入終端,通過scrapy crawl命令運行爬蟲,這里加上了--nolog選項是為了專注于print的輸出

scrapy crawl --nolog proxy_spider_demo

效果如下

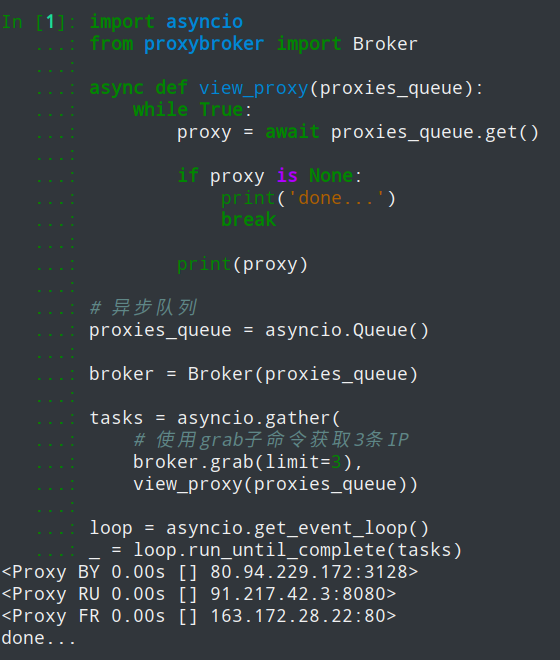

如果不希望通過serve子命令,直接在python代碼中使用代理IP,可以通過asyncio來異步獲取代理IP

直接上代碼

import asynciofrom proxybroker import Brokerasync def view_proxy(proxies_queue): while True: proxy = await proxies_queue.get()if proxy is None: print(’done...’) break print(proxy)# 異步隊列proxies_queue = asyncio.Queue()broker = Broker(proxies_queue)tasks = asyncio.gather( # 使用grab子命令獲取3條IP broker.grab(limit=3), view_proxy(proxies_queue))loop = asyncio.get_event_loop()_ = loop.run_until_complete(tasks)

獲取到代理IP后,你可以通過aiohttp異步HTTP庫或requests庫來使用它們

總結你可以利用ProxyBroker庫來白嫖免費的IP代理,但是白嫖來的始終是有缺點的,不然也不會有人專門去賣IP代理了

白嫖來的IP有穩定性差、速度慢的缺點,所以土豪可以忽視本文...

到此這篇關于python利用proxybroker構建爬蟲免費IP代理池的實現的文章就介紹到這了,更多相關python IP代理池內容請搜索好吧啦網以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持好吧啦網!

相關文章:

網公網安備

網公網安備